L’impatto che l’utilizzo dell’intelligenza artificiale può avere sul giornalismo, sulla diffusione delle notizie e sul modo con il quale le apprenderemo, è ancora tutto da verificare, ma si annuncia assai significativo. Con conseguenze ancora tutte da valutare anche dal punto di vista del diritto e della tutela della privacy in particolare.

Nuovi modelli di notizia

Di certo siamo davanti a una vera e propria rivoluzione che avanza a passi spediti ogni giorno. Grandi gruppi editoriali come Condé Nast, News Corp e RCS MediaGroup stanno stringendo accordi con aziende come OpenAI, aprendo i loro vasti archivi di contenuti per addestrare i modelli di linguaggio di nuova generazione. Ma questa partnership, apparentemente vantaggiosa per tutti, nasconde insidie significative, sia sulle modalità con le quali i modelli di Ai tratteranno le notizie, sia per le ripercussioni sul lavoro futuro del giornalista e, non ultimo, anche dal punto di vista della tutela della privacy e dei dati sensibili.

Privacy e dati sensibili

I modelli di linguaggio, come quelli utilizzati da ChatGPT, apprendono da enormi quantità di testo. Quando un giornale concede l’accesso ai propri archivi, sta di fatto “alimentando” questi modelli con informazioni che potrebbero includere dati personali sensibili. Anche se un individuo ottiene la rimozione di un articolo da un sito web, le informazioni contenute in quell’articolo potrebbero persistere all’interno del modello di linguaggio, rendendo difficile, se non impossibile, cancellarle completamente.

Diritto all’oblio sempre più a rischio

Il diritto all’oblio è un principio fondamentale che permette a un individuo di chiedere la rimozione di informazioni personali considerate obsolete, inesatte o lesive della propria reputazione. Questo diritto, sancito dal GDPR (Regolamento Generale sulla Protezione dei Dati), pare destinato a entrare in conflitto con l’utilizzo massiccio dei dati giornalistici nell’addestramento dei modelli di linguaggio.

Informazioni false e manipolazione

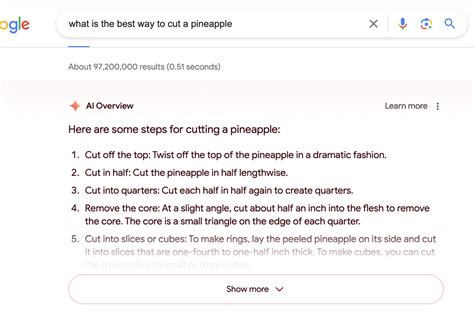

Oltre alla violazione della privacy, potremmo assistere anche alla diffusione di informazioni false o obsolete: I modelli di linguaggio potrebbero generare contenuti imprecisi o addirittura falsi basandosi su dati errati o incompleti. Magari destinate anche alla manipolazione dell’opinione pubblica: L’Ai potrebbe essere utilizzata per generare notizie false o tendenziose e influenzare l’opinione pubblica, arrivando anche a minare la fiducia nei media tradizionali.

Le sfide per il futuro

La crescente integrazione tra AI e giornalismo pone sfide complesse per garantire la protezione dei dati personali, la qualità dell’informazione e il rispetto dei diritti fondamentali. È necessario un dibattito pubblico più ampio su questi temi, coinvolgendo esperti di diritto, tecnologia, giornalismo e etica. Lo sfondo sul quale si muove anche il TgWebAi nato proprio per essere un laboratorio di studio al confine di una rivoluzione che dobbiamo riuscire a governare.

Di certo occorre lavorare per arrivare a una regolamentazione chiara che definisca un quadro normativo specifico per l’utilizzo dell’AI nel giornalismo, che tenga conto sia delle opportunità che dei rischi. In un quadro di massima trasparenza e responsabilità chiare.

Al contempo di sede lavorare all’educazione e alla formazione dei cittadini per metterli nelle condizioni di potere fare un uso critico delle informazioni generate dall’Ai e di riconoscere le fake news.