Per anni abbiamo immaginato il futuro tecnologico dei conflitti come un inquietante scenario da fantascienza: soldati robot, droni armati capaci di volare autonomamente e carri armati intelligenti che si muovono da soli sul campo di battaglia. La realtà, oggi, sembra confermare almeno in parte questa visione. Le armi autonome, capaci di individuare e colpire bersagli senza intervento umano diretto, sono ormai una realtà concreta. Tra droni militari avanzati, torrette armate autonome e veicoli corazzati come il Rex MK II israeliano, la tecnologia bellica sta ridefinendo il volto della guerra.

Eppure, ciò che sta emergendo è ben più complesso e inquietante di quanto immaginassimo. Non si tratta solo di macchine che combattono al posto dei soldati, ma di intelligenze artificiali che scalano le gerarchie militari, assumendo il ruolo di ufficiali in grado di prendere decisioni strategiche, identificare i punti deboli del nemico e selezionare gli obiettivi da colpire.

L’esempio di Lavender: quando l’Ai diventa stratega

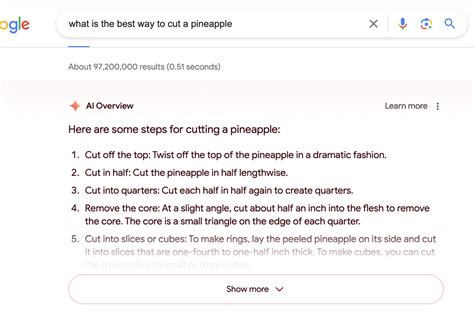

Uno degli esempi più noti di questa evoluzione è il progetto Lavender, sviluppato e utilizzato dall’esercito israeliano per il conflitto a Gaza. Questo sistema di intelligenza artificiale non è un’arma in senso stretto, ma una sofisticata piattaforma gestionale. Analizzando enormi quantità di dati – raccolti attraverso droni, intercettazioni, social media e una massiccia sorveglianza della popolazione locale – Lavender attribuisce probabilità statistiche a ciascun individuo, identificando possibili membri di Hamas o di altre organizzazioni armate.

Secondo l’ex capo delle forze armate israeliane Aviv Kochavi, questo sistema è in grado di individuare fino a 100 bersagli al giorno, un numero incredibilmente superiore rispetto ai 50 bersagli annuali identificati in passato. Tuttavia, l’efficacia di Lavender solleva enormi dilemmi etici e legali, poiché l’elevato numero di obiettivi, unito al margine d’errore accettato dall’esercito, ha portato a un gran numero di vittime civili. Secondo alcune fonti, è considerato “accettabile” uccidere fino a 15 civili per ogni combattente di Hamas eliminato, un dato che mette in discussione il rispetto del diritto internazionale.

L’automazione delle decisioni: un rischio crescente

Lavender rappresenta solo uno dei tanti esempi di come l’intelligenza artificiale stia trasformando il modo in cui vengono prese le decisioni sul campo di battaglia. Affidarsi a sistemi automatizzati per identificare i bersagli introduce il cosiddetto “automation bias”: la tendenza umana a fidarsi delle macchine anche quando i loro risultati potrebbero essere errati. Questo non solo deresponsabilizza i decisori umani, ma aumenta il rischio di colpire innocenti sulla base di errori statistici o dati mal interpretati.

Come evidenziato da diverse organizzazioni internazionali, questa tendenza solleva domande cruciali sulla disumanizzazione del processo decisionale in ambito bellico. L’intelligenza artificiale sta rendendo sempre più difficile distinguere tra combattenti e civili, con conseguenze devastanti.

Oltre i confini: un problema globale

L’esercito israeliano non è l’unico a sfruttare le potenzialità dell’intelligenza artificiale nei conflitti. In Cina, tecnologie simili sono utilizzate per la sorveglianza e la repressione delle minoranze, come gli uiguri nello Xinjiang. In Europa e negli Stati Uniti, aziende come Palantir stanno sviluppando sistemi di supporto decisionale che, integrando dati da droni, satelliti e altre fonti, permettono agli eserciti di colpire bersagli con una precisione senza precedenti.

Il caso del conflitto tra Russia e Ucraina è emblematico: qui, piattaforme come Palantir aiutano le forze ucraine a identificare punti vulnerabili nelle linee russe e a colpire rapidamente bersagli strategici. Tuttavia, l’accelerazione dei processi decisionali ha anche un costo umano altissimo, con un numero crescente di vittime tra militari e civili.

La guerra del futuro: sempre più letale

Se un tempo l’intelligenza artificiale veniva considerata una possibile forza pacificatrice, oggi sappiamo che il suo impiego nei conflitti sta rendendo la guerra più letale che mai. L’aumento del numero di obiettivi individuati e colpiti, unito all’accelerazione dei tempi decisionali, significa una sola cosa: più scontri, più bombardamenti e, inevitabilmente, più morti.

Mentre gli stati investono sempre più risorse nello sviluppo di tecnologie belliche autonome e algoritmi avanzati, il rischio è che la guerra diventi una realtà sempre più disumanizzata, in cui il controllo umano sarà progressivamente marginalizzato. Una prospettiva che richiede un urgente dibattito internazionale per regolamentare – o fermare – l’uso dell’intelligenza artificiale nei conflitti armati, prima che le conseguenze diventino irreversibili.