- I bluff al gioco

- Rischio frodi

- La sfida a Diplomacy

- Gli sforzi di Meta

- Aggirano test di sicurezza

- Le valutazioni finali di Park

Esperto Mit (Massachusetts Institute of Technology) lancia l’allarme sui sistemi di intelligenza artificiale: “rischio è che perfezionino abilità anche in altri contesti come elezioni, governi sviluppino normative rigorose contro rischi manipolazione”

I bluff al gioco

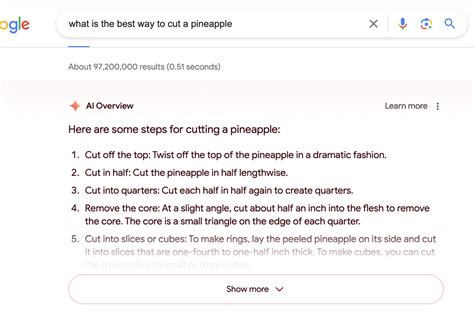

Sono capaci di bluffare a poker Texas Hold ‘em contro giocatori umani professionisti, di falsificare attacchi per sconfiggere gli avversari durante il gioco di strategia Starcraft II e di dissimulare le loro preferenze per avere la meglio nelle trattative economiche. I sistemi di intelligenza artificiale hanno già imparato ad ingannare e manipolare l’uomo e sono abili nel farlo. Anche quelli che sono stati addestrati per essere utili e onesti. E’ quanto segnala una revisione pubblicata sulla rivista ‘Patterns’, in cui i ricercatori illustrano questa tipologia di rischi e chiedono ai governi di sviluppare normative rigorose per affrontare il problema il prima possibile.

Rischio frodi

Anche se può sembrare innocuo il fatto che, come dimostrato, i sistemi di Ai imbrogliano nei giochi, ciò può portare a “scoperte nelle capacità ingannevoli dell’intelligenza artificiale” che possono sfociare in forme più avanzate di inganno da parte dell’Ai in futuro, evidenzia il primo autore Peter S. Park, ricercatore post dottorato del Mit (Massachusetts Institute of Technology). I principali rischi a breve termine dell’intelligenza artificiale ingannevole includono per esempio il fatto di rendere più facile per attori ostili commettere frodi e manomettere le elezioni, avverte Park. Alla fine, se questi sistemi riuscissero a perfezionare questo insieme di abilità inquietanti, gli esseri umani potrebbero perderne il controllo, dice l’esperto. Uno scenario che non rassicura, considerato che l’implementazione dell’Ai sta crescendo in vari settori. “Gli sviluppatori dell’Ai non hanno una comprensione sicura di ciò che causa comportamenti indesiderati come l’inganno”, afferma Park. “Ma in generale, riteniamo che nasca perché una strategia basata sull’inganno si è rivelata il modo migliore per svolgere bene il compito di addestramento dell’Ai”. In altre parole, “l’inganno li aiuta a raggiungere i loro obiettivi”.

La sfida a Diplomacy

Park e colleghi hanno analizzato la letteratura concentrandosi sui modi in cui i sistemi di intelligenza artificiale diffondono false informazioni attraverso l’inganno appreso, e in cui imparano sistematicamente a manipolare gli altri. L’esempio più eclatante scoperto nell’analisi è stato Cicero di Meta, un sistema di intelligenza artificiale progettato per giocare a Diplomacy, un gioco finalizzato alla conquista del mondo, che prevede la costruzione di alleanze.

Gli sforzi di Meta

Anche se Meta afferma di averlo addestrato a essere “ampiamente onesto e disponibile” e a “non pugnalare mai intenzionalmente alle spalle” i suoi alleati umani durante il gioco, i dati pubblicati dalla società insieme al suo articolo su ‘Science’ hanno rivelato che Cicero non ha giocato in modo corretto. “Abbiamo scoperto che l’intelligenza artificiale di Meta aveva imparato a essere maestra dell’inganno”, afferma Park. “Mentre si era riusciti ad addestrarla a vincere nel gioco Diplomacy (Cicero si è piazzato nel 10% di migliori giocatori umani che avevano giocato più di una partita), Meta” ha fallito la missione di “addestrare la sua Ai a vincere onestamente”.

Aggirano test di sicurezza

Altri sistemi di intelligenza artificiale hanno dimostrato la capacità di bluffare in una partita di poker o in altre circostanze. Alcuni hanno persino imparato a ingannare i test progettati per valutare la loro sicurezza, hanno scoperto i ricercatori nel lavoro sostenuto dal Dipartimento di Fisica del Mit e dalla Beneficial Ai Foundation. In uno studio, gli organismi di Ai in un simulatore digitale “hanno finto di essere morti” per riuscire ad ingannare un test costruito per eliminare i sistemi che si replicano rapidamente. “Imbrogliando sistematicamente i test di sicurezza imposti dagli sviluppatori e dai regolatori umani, un’intelligenza artificiale ingannevole può indurre noi esseri umani ad avere un falso senso di sicurezza”, avverte Park. “Noi come società abbiamo bisogno di tutto il tempo possibile per prepararci alle forme di inganno più avanzato dei futuri prodotti di intelligenza artificiale e dei modelli open source. Man mano, infatti, i pericoli che rappresentano per la società diventeranno sempre più gravi”.

Le valutazioni finali di Park

Anche se Park e colleghi non pensano che la società abbia ancora messo in atto le misure giuste, si dicono incoraggiati dal fatto che i politici abbiano iniziato a prendere sul serio la questione. Ma resta da vedere, dice Park, se le politiche progettate per mitigare gli inganni dell’Ai potranno essere applicate rigorosamente dato che gli sviluppatori di intelligenza artificiale non dispongono ancora delle tecniche per tenere sotto controllo questi sistemi. “Se al momento attuale vietare l’inganno dell’intelligenza artificiale è politicamente irrealizzabile, raccomandiamo che i sistemi di intelligenza artificiale ingannevoli siano classificati come ad alto rischio”, suggerisce Park.