- Un rischio senza confini: il potenziale distruttivo dei deepfake

- Il diritto contro i deepfake: una sfida ancora aperta

- Privacy e diritto d’immagine: strumenti ancora deboli

- Come affrontare l’emergenza

- Nuova formazione per avere utenti e cittadini consapevoli

- Scelte coraggiose e rapide

I deepfake rappresentano una delle minacce più inquietanti dell’era digitale. Dietro la straordinaria capacità tecnologica dei nuovi sistemi di Ai di riprodurre fedelmente immagini, voci e movimenti di persone reali, si cela il rischio di manipolazioni che mettono a repentaglio privacy, reputazione e persino la stabilità sociale. Più che frutto di una semplice innovazione tecnologica, i deepfake sono il simbolo di un potere capace di riscrivere la realtà a proprio piacimento. E oggi, il diritto si trova ad affrontare una sfida senza precedenti. Se davvero vuole arrivare a proteggere tutti gli utenti, anche i meno attrezzati tecnologicamente.

Un rischio senza confini: il potenziale distruttivo dei deepfake

Non si tratta più di scenari futuristici. Politici, giornalisti e semplici cittadini sono già stati vittime di frodi, campagne diffamatorie e revenge porn. I deepfake non sono solo strumenti di intrattenimento o innovazione, ma vere e proprie armi digitali. L’ultimo caso italiano, che ha visto il volto di due noti giornalisti economici “usato” per promuovere una truffa finanziaria, sottolinea quanto sia pervasiva e pericolosa questa tecnologia. E il potenziale impatto dannoso che può avere nella costruzione della società del futuro. Ma a far discutere ancora di più nelle ultime ore è stato il video che immortala un bacio, ovviamente falso, tra Elon Musk e la premier italiana Giorgia Meloni.

La velocità con cui questi contenuti possono essere creati e diffusi supera di gran lunga la capacità delle piattaforme e delle leggi di reagire. Anche quando vengono rimossi, il danno è già stato fatto: la reputazione delle vittime compromessa e la fiducia degli utenti erosa.

Il diritto contro i deepfake: una sfida ancora aperta

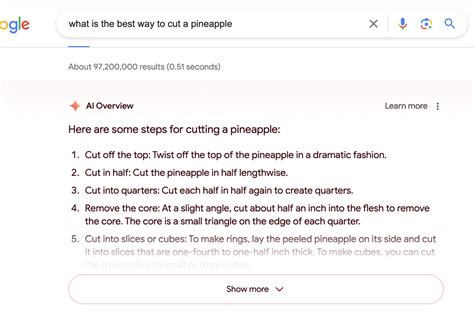

Il panorama normativo europeo è articolato, ma insufficiente nel suo complesso. Il Digital Services Act e l’Ai Act sono due strumenti chiave nella strategia dell’Unione Europea, ma presentano limiti evidenti. Il DSA, ad esempio, impone alle piattaforme digitali di rimuovere i contenuti illegali, ma si basa su un modello reattivo: le piattaforme agiscono solo dopo una segnalazione, lasciando un margine per la diffusione incontrollata dei contenuti manipolati.

L’AI Act, d’altro canto, classifica i deepfake come tecnologie “ad alto rischio” e impone obblighi di trasparenza per i produttori di sistemi di intelligenza artificiale. Tuttavia, la normativa si concentra prevalentemente sugli sviluppatori e non affronta in modo adeguato gli usi criminali o privati di queste tecnologie. Inoltre, la difficoltà tecnica di rilevare i deepfake in tempo reale rende questi strumenti normativi deboli di fronte alla rapidità con cui la tecnologia avanza.

A livello nazionale, l’Italia ha avviato un percorso promettente con il ddl delega sull’intelligenza artificiale, che introduce una nuova fattispecie di reato nel codice penale: l’articolo 612 quater, intitolato «Illecita diffusione di contenuti generati o alterati con sistemi di intelligenza artificiale». Una norma che colpisce chiunque diffonda contenuti falsificati con Ai, causando danno a una persona e inducendo in inganno sulla genuinità del contenuto. Un passo avanti significativo, ma che deve essere accompagnato da strumenti concreti di applicazione immediata.

Privacy e diritto d’immagine: strumenti ancora deboli

Il diritto alla privacy e il diritto all’immagine, pilastri della tutela individuale, mostrano tutta la loro fragilità nel tenere il passo rispetto alla rapida evoluzione del mondo digitale. Se il GDPR offre una protezione parziale, vietando l’uso dei dati biometrici senza consenso, non riesce a coprire scenari complessi come quelli legati ai deepfake. Identificare gli autori, bloccare la diffusione e riparare il danno sono compiti che richiedono strumenti ben più avanzati e rapidi.

Oggi, una volta che un contenuto deepfake viene diffuso, il danno è spesso irreparabile. E il diritto, che dovrebbe garantire protezione e giustizia, si trova spesso un passo indietro rispetto alla tecnologia.

Come affrontare l’emergenza

Se davvero si vuole affrontare questa emergenza, è necessario un salto di qualità. Alcune proposte emergono sono già emerse con forza: 1) Estensione del GDPR: includere specifiche norme sui dati biometrici indiretti per tutelare anche chi viene colpito da manipolazioni digitali non autorizzate; Revisione del DSA: imporre alle piattaforme l’uso obbligatorio di tecnologie per il riconoscimento dei deepfake, con blocchi automatici per i contenuti falsi; Rafforzamento dell’AI Act: obbligare i produttori di IA a integrare strumenti di verifica della genuinità nei loro sistemi; Campagne di sensibilizzazione: informare cittadini e professionisti sui rischi dei deepfake, affinché sappiano riconoscerli e difendersi.

Ma non basta intervenire a livello normativo. Serve una stretta collaborazione tra governi, aziende tecnologiche e società civile per sviluppare standard globali di sicurezza e responsabilità.

Nuova formazione per avere utenti e cittadini consapevoli

Di pari passo all’evoluzione del diritto è indispensabile che si guardi in maniera diversa al mondo della formazione e delle competenze digitali. Spesso la rapidità con cui si dipana il progresso tecnologico lascia inevitabilmente degli spazi vuoti per mettere in atto una concreta attività di contrasto da parte degli Stati. Così come provare ad imbrigliare tutto con norme draconiane e eccessivamente stringenti può avere ricadute negative sulla velocità del progresso e rallentare anche gli utilizzi leciti e proficui dei sistemi di Ai. Un punto saldo per affrontare il futuro è quello di fornire ai cittadini e agli utenti la formazione necessaria per essere sempre più consapevoli nell’utilizzo delle nuove tecnologie. Partendo fin dagli utenti più giovani, magari inserendo anche nei primi cicli di istruzione percorsi in grado di preparare i ragazzi al mondo digitale in cui sono totalmente immersi fin dalla nascita.

Scelte coraggiose e rapide

La lotta contro i deepfake è, prima di tutto, una lotta per la verità. In un mondo dove la manipolazione digitale può riscrivere la realtà, il rischio è quello di perdere il controllo sulla percezione pubblica e privata. Se il diritto non riesce a tenere il passo con l’innovazione tecnologica, il rischio è quello di consegnare questo potere nelle mani di pochi, mettendo a repentaglio i fondamenti stessi della democrazia e della fiducia sociale.

È il momento di agire, di prendere decisioni coraggiose e di costruire un sistema che garantisca non solo la protezione degli individui, ma anche la salvaguardia della verità e la formazione dei cittadini. Perché la posta in gioco non è solo il diritto all’immagine o alla privacy: è il futuro stesso della nostra società.